DeepSeek R1 重写 o1 和未来推理大语言模型的方法DeepSeek R1's recipe to replicate o1 and the future of reasoning LMs

是的,为 DeepSeek R1 确立真正的 o1 复制铃声 🔔🔔🔔。我们下一步会去哪里?Yes, ring the true o1 replication bells for DeepSeek R1 🔔🔔🔔. Where we go next.

这周我有几部剧要和大家分享:

在一周前的《回击》中,我们讨论了人工智能的本质,以及它是否属于科学(Kuhn 的观点)

我在 Dean W. Balland 的新播客《AI Summer》中讨论了“思考模型”和训练方法与推理方法之间的区别。点击这里收听。

最后,我在 NeurIPs 上关于 AI 应用后训练的思考的演讲现在公开了。

这个帖子可能在邮件中被截断——我建议在线阅读,点击标题即可!

昨天,1 月 20 日,中国开放权重前沿 AI 实验室 DeepSeek AI 发布了首个完整推理模型。

旗舰推理语言模型 R1,通过 4 阶段的强化学习方法训练。它采用 MIT 许可,这意味着公司和研究人员可以利用其输出进行开发和训练,以加速推理语言模型(RLMs)的开发和部署。

一个仅使用 RL 训练的推理模型,直接从 V3 基础模型 R1-Zero(用于生成全 R1 训练数据)训练。

使用 R1(类似中间训练步骤的数据)生成的监督微调数据微调的模型套件。

一份技术报告,详细介绍了他们的强化学习训练方法。

模型可在 chat.deepseek.com(通过 DeepThink)访问,或在新应用中使用。

这篇帖子不是关于评估结果(当然,这些结果非常出色,详见下文),而是关于训练过程和其意义。

这是推理模型研究中一个重要的转折点。在此之前,推理模型一直是工业研究的一个重要领域,但没有明确的奠基性论文。在语言模型之前,我们有 GPT-2 论文用于预训练,还有 InstructGPT(以及 Anthropic 的白皮书)用于后训练。对于推理而言,我们只能看到可能误导的博客文章。 推理研究和进展已停滞——2025 年将有巨大进步,未来还将继续。

这再次证明了新技术配方通常不是垄断——概念验证或泄露通常会传播知识。

首先,看看这些推理模型的价格。OpenAI 为它的模型收费更多,因为需要处理长上下文和是唯一在场的模型,但 o1 的价格为每百万输入 token 15 美元 / 每百万输出 token 60 美元(相对于 R1 的价格为每百万输入 token 0.55 美元 / 每百万输出 token 2.19 美元),o1-mini 的价格更低至每百万输入 token 3 美元 / 每百万输出 token 12 美元(但差距依然接近十倍)。 推理模型的价格战将与 2023 年的 Mixtral 推理价格战相似。

使用 o3,OpenAI 可能在技术上领先,但尚未广泛可用,权重也尚未随时准备就绪。这表明自 Stable Diffusion 发布以来,最相关且讨论的 AI 模型首次以友好的许可证发布。回顾过去 2.5 年间开源 AI 的发展,这一时刻在历史书上留下了印记。

我们还不完全清楚这些模型未来将如何应用,除了代码和数学之外,但不断有声音表明 OpenAI 的 o1-Pro 在许多更具挑战性的任务中是最好的(我需要亲自试用后再做最终推荐)。

现在最实用的帖子是介绍研究领域、明确优缺点和提出开放问题。让我们具体来说说。

DeepSeek R1 训练推理的食谱

R1 的训练分为 4 个阶段:

R1-Zero 模型的合成推理数据上的监督微调首次启动。2

大规模推理问题的强化学习训练“直到收敛”。

在 3/4 推理问题和 1/4 通用查询上进行拒绝采样,以开始向通用模型的过渡。

强化学习训练中,将可验证的奖励与通用偏好调整模型结合,以优化模型。

下面,帖子将每个训练阶段分为核心组件、见解和开放问题。

o1 复制风已经强劲地远离了任何明确的搜索(尤其是在推理时)。这确实如此,而且现在也是如此,语言模型通过大量的 RL 训练获得了新的推理行为。

在开始之前,记住要很好地进行推理训练,需要一个强大的模型,能够处理长上下文。就像标准的后训练一样,我们还不清楚基础模型哪些特性更适合直接的强化学习训练。

第一步:训练 R1-Zero 以用合成数据初始化 R1

DeepSeek R1 Zero 将以第一个“大规模强化学习(RL)无监督微调(SFT)作为初步步骤”训练的模型而闻名。传闻中提到过 o1,但理解其工作原理并不清楚。这是一个奇怪的模型,DeepSeek 报告说它在推理时会切换语言或显示其他可靠性问题。

R1-Zero 中的小型可用性问题表明,除了大规模的 RL 外,还需要更多内容来训练一个优秀的推理模型。而 RL 部分是解锁我们正在寻找的推理行为的关键。

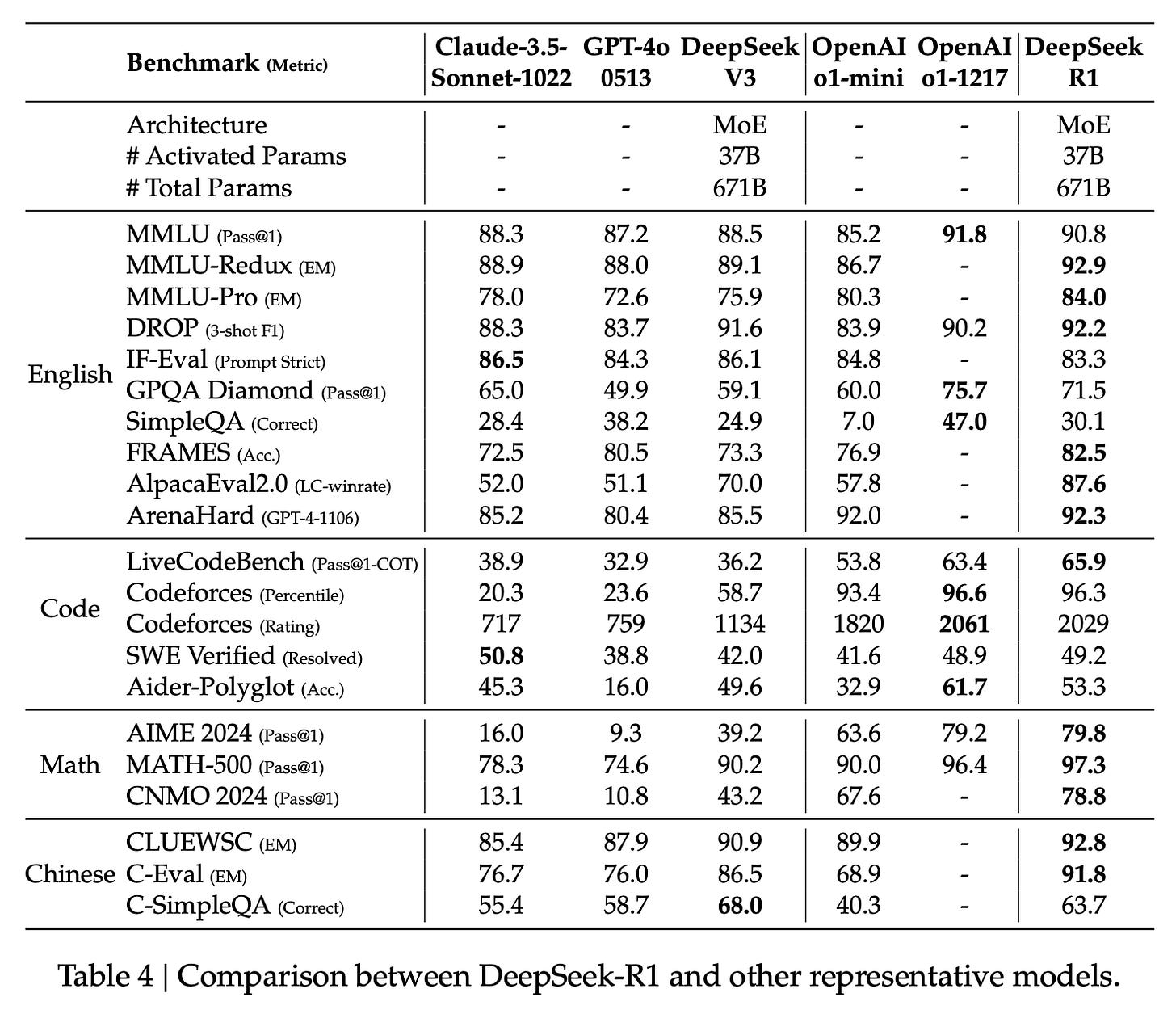

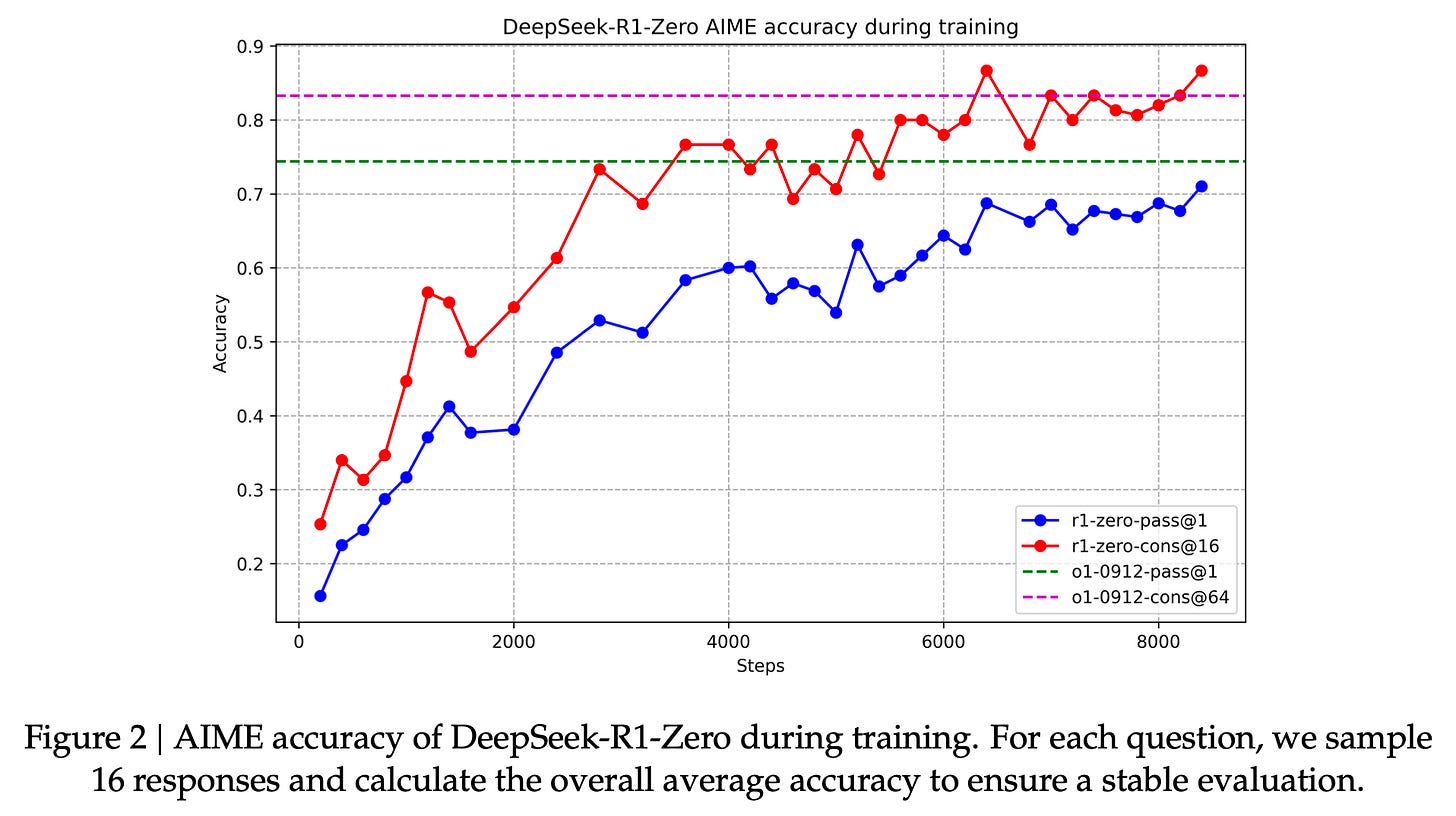

他们包括了 R1-Zero 最有趣的结果,比如我一直在要求的关于 RL 训练时间扩展的图表。自 o1 发布以来,大家对显示推理时间与评估性能相关性的图表非常关注。推理时间更容易获取(或通过使用蒙特卡洛树搜索等框架来获取),但展示通过 RL 实现的训练时间改进是真正的基础结果。这是我研究中正在寻找的结果。

剧情令人意外,但非常令人满意,随着训练长度的增长。这可以与上述剧情结合,制作出“推理时间扩展”类型的图表,这些图表我们见过很多版本,但方法更清晰。

在这两个图表中,如果让 RL 继续工作,数字可能会继续增长。由于进展速度很快,这些实验室通过结束饱和状态的工作并开始新的实验来获得更大的收益,而不是追求最后的 1%。

大多数研究者不会训练 R1-Zero 风格的模型,因为不需要。DeepSeek 显示,他们“冷启动”SFT 推理使其最终的 R1 模型更好——这并不令人意外,因为他们希望 R1 是某种特定类型的指令调优模型。这将有助于避免 DeepSeek 提到的一些 R1-Zero 中的“RL 特殊现象”,比如生成式推理过程中语言的变化。

RL-on-base-models 的研究仍需进一步深入。R1-Zero 训练方式非常巧妙,大多数没有指令调优的模型都会出现乱讲和没有停止标记的问题。R1-Zero 通过系统提示模型生成 HTML 标签来解决这个问题。此外,我怀疑这种训练方法在没有预训练数据的旧版模型上不会奏效,这些数据通常包含标准后训练风格的指令数据。 例如,在 OLMo 2 中,我们使用了部分 MATH 教训数据。几条指令就能让系统开始提示工作。

事实上,通过强化学习训练增加生成长度的趋势可能会比直接从基础模型或标准后训练模型中获得的模型更强。为了使 RL 真正开始在指令跟随模型中增加响应长度,它需要放弃一些已嵌入的响应长度。 例如,在 Tülu 3 的 RL 微调阶段,即响应率下降时,可能是由于在较小的 RL 环境之前的大规模 SFT 训练导致的对齐问题。

在这些 R1-Zero 图的 x 轴上缩放,可以看到它们进行了数百万次“RL 步骤”。这里的 RL 步骤指的是模型更新步骤,这发生在批量提示生成多个世代后,然后答案被验证。3 这是大量 RL 训练,尤其是使用如此大型的模型。参考我们的 Tülu 3 工作,在我们的工作中通常会对模型进行数百次训练,而即将发布的最大模型仅进行了约 50 次 RL 训练。

这篇论文在 RL 领域进行了扩展,与现有文献相比。R1 确实使用了类似的方法,但 DeepSeek 未包含相同细节,因此本文更多依赖于论文中的明确文本。

第一步:推理 SFT “冷启动”

为了提高最终推理模型的可读性和性能,DeepSeek 对原始模型进行了少量监督微调,使用了“几万”个从 R1-Zero 模型过滤后的完成。这涉及一些技巧(这些技巧似乎并不必要,你只需要这些数据),例如:

以使用少量提示和长链推理为例,直接引导模型生成详细且有反思的解答,并通过验证收集 DeepSeek-R1-Zero 的输出,整理成易于阅读的形式。最后,通过人工标注进行后处理来优化结果。

为了实现这些目的,可以使用其中任何一个。事实上,使用 DeepSeek-R1 本身是最简单的方法。

这一阶段准备了模型的损失函数,使“突发”行为如“等一下,让我检查一下”或“那不对”更容易在强化学习训练中出现。

步骤 2. 大规模 RL 用于推理

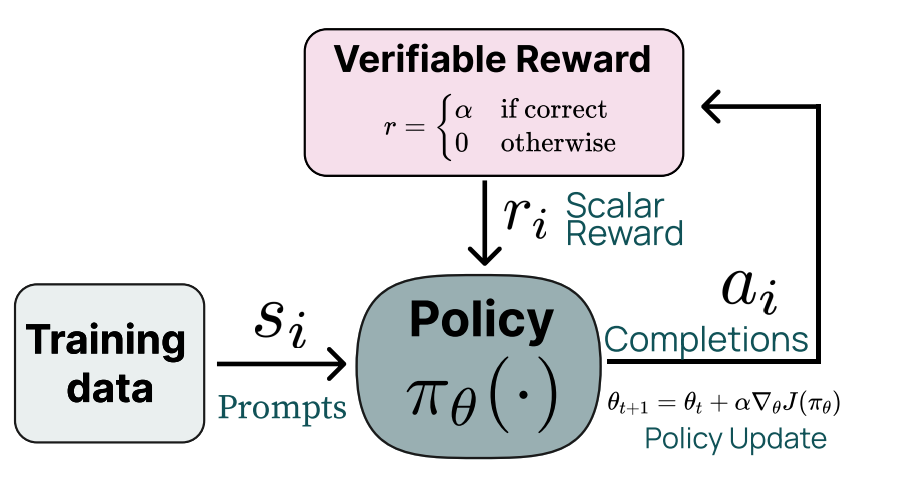

提醒一下,推理模型的强化学习基于一个简单的想法:奖励模型正确回答问题,这样可以检查答案是否正确。这种基本的反馈循环如下:

这里所说的“奖励”(R1-Zero 也是如此)的具体内容并未详细说明。DeepSeek 在 RL 的推理阶段提到了三个奖励成分:4

准确性奖励:如果回答正确,会获得分数奖励。我在 OpenAI 的强化微调中将这些称为“可验证”的领域。TLDR:如果答案正确,奖励为正;不正确则为 0.5。

格式奖励:这些是奖励(或惩罚,如果未满足)用于检查模型是否遵循 或 和 和 的正确格式,以确保稳定推理。

语言一致性奖励:如果答案的语言与问题语言完全一致,模型将获得额外奖励。DeepSeek 表示,这增加了“模型性能的轻微下降”,但符合人类的偏好。这个奖励是为了让模型更友好使用,这是一个很好的提醒,评估分数并不是所有重要的事情。

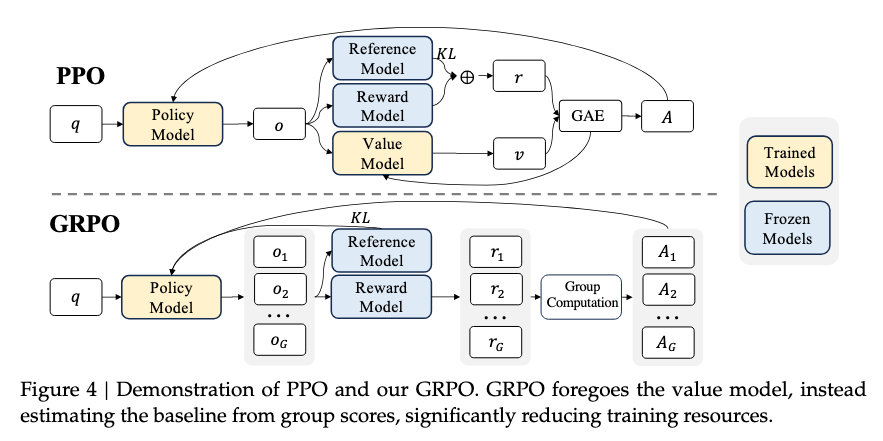

这里的主要奖励驱动了大部分学习,而其他两个是稳定模型的保障(这并不是说它们不重要,而是说第一个是必需的,而其他两个可能不是)。 为了优化奖励,DeepSeek 使用了他们引入的 RL 算法,即 Group Relative Policy Optimization(群体相对策略优化)。这种算法基于蒙特卡洛优势估计,而不是在内存中存储单独的价值模型。这种选择(就像 OpenAI 一直使用 PPO 一样)可能是由于他们在基础设施中的成熟实现。

这张来自 DeepSeekMath 论文的图片展示了 PPO 和 GRPO 的对比(如果你只关心大图谱,可以跳过这个部分):

奖励设置(包括数据)的性质是这种推理训练的关键,许多小的强化学习细节可以相互替代。

就像 DeepSeek V3 论文那样,这里没有提到他们训练模型所用的具体数据。这至关重要,很可能涉及许多可验证的提示和答案。为了研究这些模型,社区需要开放的数据集版本。

我本想看到他们 RL 基础设施的详细信息(类似于 DeepSeek V3 论文中的内容),因为很多人希望在此基础上继续研究。RL 训练需要在内存中同时存储多个模型,并交替进行生成、验证和损失操作。Sasha Rush 说:“我们需要尽快编写验证器”,我们正在 Ai2 上构建 Tülu 3,利用开源代码可以得到很多帮助。 对于这里感兴趣的实体来说,一个好方法是逐步开发工具和数据,专注于一个领域。

前两步并不是什么新东西,而是人们讨论了多年的改进版。论文中详细说明的最后两项是将已知技术应用到实际操作,以提升原始推理能力,从而“训练出用户友好的模型”。

第 3 步:拒绝采样引入通用能力

拒绝采样是一种技术,其中你从模型中生成完成,通过奖励模型进行排序,然后对原始模型(通常使用监督微调损失)进行微调以提高多种任务的性能。这是 Llama 3 和许多其他模型常用的后训练工具之一。

DeepSeek 使用拒绝采样来引入模型的通用能力。这是其中的一个阶段,包含数据量——总计 800K,分为推理 600K 和聊天问题 200K。这个 800K 的数字对我来说并不意外,因为这只是一个晚期的 SFT 训练。与我们在 Tülu 3 SFT 混合中使用的约 1M 前提条件相似,这个数字大致符合领先的后训练方法。

论文中提到的细节主要围绕生成响应和过滤高质量训练数据的方法。为了使模型在更多领域表现优秀,DeepSeek 采用了多种技巧,例如:

使用生成奖励模型(即 LLM-作为裁判)来验证那些可能不明确可验证的问题。

来自 DeepSeek-V3 标准后训练流程的数据,以及

标准(不可验证)的聊天数据,通过在回答前扩展思考链,帮助模型从推理训练中推广到更广泛的应用场景。

目前我们这里细节不多,还有很多空白可以学习(也有可能改进)。

第 4 步:用于通用的最终强化学习训练

最后,DeepSeek R1 再次转向强化学习,这似乎已成为当今大多数微调的最终目标。第二阶段的目标是提高模型的有用性和无害性,同时提升其推理能力。

为了实现这一点,他们进行了 RL 训练,将可验证领域的提示与标准的 RLHF 调优提示混合。为了完成这项任务,他们使用了多个奖励模型,并在 DeepSeek V3 的后训练方法上进行了改进。

这并不容易做到,涉及许多问题:数据平衡正确吗?可以使用现成的奖励模型吗?需要看到长期推理轨迹吗?还需要额外步骤以保持性能吗?还有其他问题。

随着这一领域的发展,这些问题将逐渐得到解答。

随着这篇帖子进入训练的后期阶段,很多细节尚不清楚。我们已经掌握了如何排列事物的大体方法,从这里开始补充细节。我有大量与推理相关的研究论文需要阅读,尽管它们发表在 DeepSeek R1 之前,但仍然会指向答案。

这一切都能解决,正如 DeepSeek 从 o1 发布到与开放权重模型性能相当的速度所证明的那样。

讨论和下一步计划

DeepSeek R1 报告中有一个专门的子部分,介绍了其蒸馏实验。他们从 R1 模型中提取了完成任务的数据,并用这些数据对现有的开放权重模型进行了微调,以提升性能。这为他们发布这项服务提供了有力的支持,并为未来的小型模型 RL 实验提供了坚实的基础,旨在在未来接近匹配。

论文中关于如何使用大模型获得最大推理收益(并生成有效合成数据)的讨论,可能是目前最大的未解决问题:

首先,将更强大的模型简化为较小的模型能取得优异效果,而依赖于本文中提到的大规模 RL 的小型模型需要巨大的计算资源,甚至可能无法达到简化的效果。其次,虽然蒸馏策略既经济又有效,但超越智能的界限可能仍需要更强的基础模型和更大的规模强化学习。

随着小型模型的不断改进,同样的训练方法可能也适用于像 Llama 5 或 6 8B 这样的大模型。这让我们对为什么在更大规模的模型中出现不同的能力感到困惑。规模定律是为什么每一代前沿模型通常是最大的可用模型的原因。2025 年对这个问题的令人兴奋的形式是:2025 年,语言建模研究中的缓慢进展将如何推动高级推理能力的发展?

每隔一段时间,就会有一篇论文出来,让前进的方向更加清晰。上次我有这样的感觉是关于 Llama 3 训练报告的 Tülu 3 论文。

很快,我将评论……

从推理路径中提取(如 R1 论文中所示)

过程奖励模型(PRMs)和蒙特卡洛树搜索(MCTS)的消亡,

DeepSeek 论文中的一些问题,比如“Aha”顿悟和对人类先验的过度依赖,让我感到有些烦人

来自学术界的最新推理研究,

昨天发布的另一个推理模型 —— Kimi 1.5,

Tülu 3 RLVR 最大的应用,以及

所有正在推理模型空间中讨论的其他想法。

R1 未必是训练这些模型的唯一方法,但它是人们会立即构建的方案。让我们开始更多数据集和基础设施建设吧。

对于新来的人,你可以看看 Interconnects 上的推理与推理标签!

要对模型的接近程度感到自信,需要大量工作。如果我必须选择,我会选 OpenAI,因为他们的用户群体更大,我认为他们更倾向于最大化实际效果而不是评估分数。随着时间的推移,我会表达更强烈的观点。但初步对话让我认为 R1 模型在范围内。

我不将生成推理数据视为步骤 0,因为现在可以用 R1、Qwen QwQ 或替代品轻松实现。很快,HuggingFace 上就会有很多内容了。

在我们的 Tülu 3 论文中,我们通常报告的事件数量与步骤数相关,因为生成和验证的总提示次数。事件数量与批量大小乘以 RL 步骤数成正比。

DeepSeek 说他们“直接相加”这些奖励,但不知道具体的比例和形状,这并不特别有洞察力。

或者这个的缩放或形状版本。

罗斯·泰勒也在询问奖励塑造,这与验证者密切相关。

Subscribe to Interconnects

The cutting edge of AI, from inside the frontier AI labs, minus the hype. The border between high-level and technical thinking. Read by leading engineers, researchers, and investors on Wednesday mornings.