统计7676篇机器之心文章标题,尝试寻找三大会的独特“味道”

这是一个非常有趣的探索,今天晚上在一个群聊里,聊到一篇很火的三大会文章,但标题起的比较夸张(不用举例子,三大会的标题都比较类似)。大家作为领域相关的一线同学,对这种过分夸张的标题,一般会比较排斥~

但很明显,三大会这么起标题,是一个非常复杂的现象。三大会的主要受众,一般是受过一定教育的、对AI感兴趣的大多数人,以及没有时间和精力亲自follow最新论文和技术的导师和企业管理层。对于大多数人来说,三大会还是有一定的信息筛选能力,能够让大家用比较少的时间和注意力,获取的一些比较主流的AI进展。但如果不起UC震惊体的标题,浏览量可能就会下降很厉害,这里具体的关系我也没有拿到详细的统计数据,如果三大会的小编看到了,欢迎交流。

其实,现在学术届和工业界确实会把在三大会的宣传和报道,当成了一个追求目标。当它们真的占据了同行门的注意力时,你的工作能够得到他们的报道,也是一种影响力的体现。

除非我们能有一个主流且权威的 论文 中文翻译-总结-评价-推荐的平台,否则这种信息筛选的生态位总归是存在的。

说回来,我们为什么会“讨厌”他们的标题呢?

大家都在说他们的文章标题“味道”很重,那么这个“味道”究竟是什么?

我想找一个量化的指标,来揭秘一下这个所谓的“味道”。

第一步,我先搜集了一下机器之心的标题,从2018年到2024年,搜集了7676个文章标题(可能不全,但应该是符合整体分布)

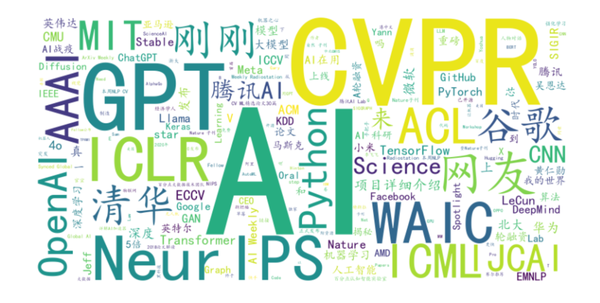

第二步,尝试绘制词云。使用常见的wordcloud库,拿到的结果很差。

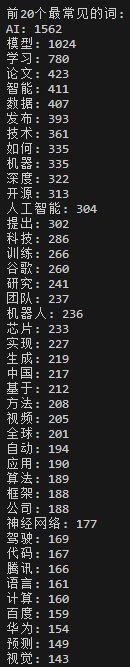

第三步,这里词云的分词规则,我并不清楚,设置的热词也不生效,所以就放弃了这个方案。进而采用jieba分词,查看词频。

这里我们发现了一个诡异的问题,我找不到GPT-4V和4o的词频,我明明在文档中搜到了九十多个4V。原来jieba分词,哪怕设定了热词,它也会将-这样的特殊符号当成切分词,所以一直会被拆散。这个方案也不够好使。

第四步,尝试使用LLM做分词。这里我们试了好几个模型,换了好几套提示词,都没有拿到特别好的结果,大模型很难把词分的特别细。

第五步,去群里,将标题文档传到群里,咨询群友。在一堆乐子人群友的帮助下,我们展开了多智能体的多样化探索。

多群友探索:

- shom群友首先尝试many shot的标题生成:

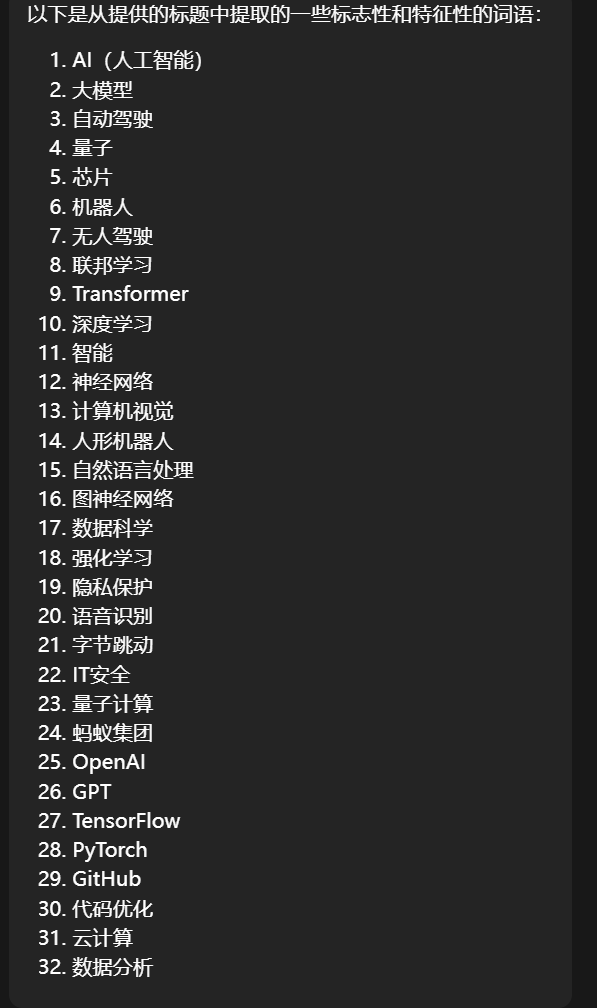

2. shom继续利用128K模型做信息直接抽取:

3. 受到群友启发,我准备尝试一下 “人工”智能,我要肉眼统计一下这7676个标题,毕竟我还是有点先验的。

在我刷了一半左右的时候,我贴出了下面的答卷:

我肉眼shot的结果,大概是一些特殊词汇,刚刚!突发!颠覆!惊人!揭秘!第一!爆火!超!打脸!冷水!官宣!福利,率先,大厂、名校和名人的title

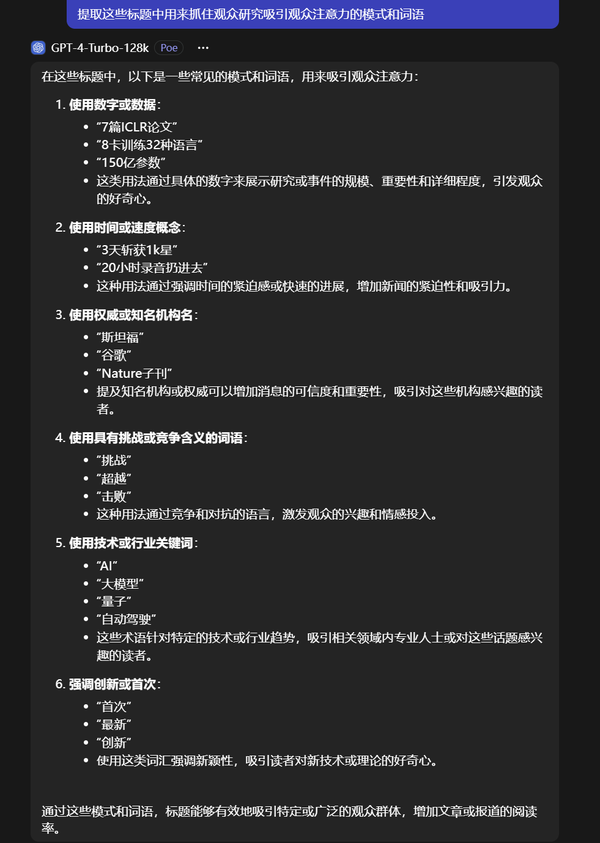

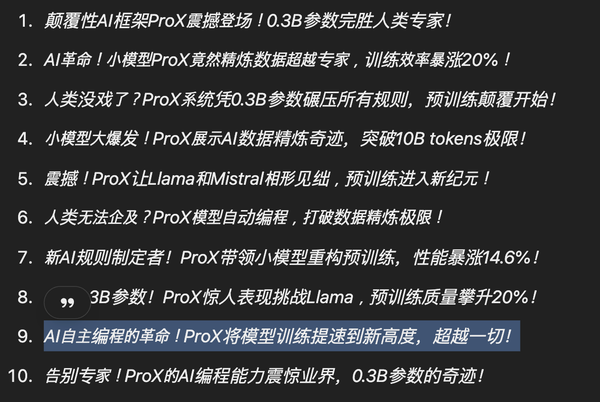

4. 几乎同时,shom跟4T-128k交互,得到了新的结果:

shom:进行 Chain of Hype 可以有效提升 Hyperative Writing 的能力

5. 这时候人工队还要辛苦八分钟,才交上了最终的答卷:

刚刚!突发!颠覆!惊人!揭秘!第一!爆火!超X!打脸!冷水!官宣!首发!福利!率先!最X!独家!仅需!媲美!加速!提升!SOTA!斩获!手把手!打破!抢先!原理!震撼!点赞!宣告!抛弃!重磅!反转!硬核!一键!远超!知名!高达!首款!优雅!狂欢!带火!发布!曝光!新型!开源!

大厂、名校和名人的title

6. 最后,小舟哥提供了一个“三大会”标题生成提示词模板:

7. 本乐子人,最终还是熬夜将这个帖子攒出来了,供大家图一乐。

总结

三大会“味道”的量化评估和精细化分析,还没有做完,等我国庆有空,细细填坑~

在朋友的提醒下,接下来要探索的方向,是将这些评论做分类统计,应该可以获得一个量化指标,如果大家有其他的想法,欢迎评论区讨论交流~

虽然但是,还是很荣幸ProX在这里成为了test case,这里有个简单的中文介绍:SinclairWang:语言模型预训练数据工程:节省20倍计算量,实现显著性能提升!

欢迎讨论,求轻喷 :)

曝光! 掌握这些标题命名原理, 你也能登上三大会巅峰!

看看三大顶号的评论区就知道,有什么样的读者,就有什么样的reward hacking结果![[飙泪笑]](https://pic4.zhimg.com/v2-3bb879be3497db9051c1953cdf98def6.png) 衍生乐子:建议给这群顶号忠实粉丝建个画像

衍生乐子:建议给这群顶号忠实粉丝建个画像

笑死,好活