一直比较关注语音(和视频)这块,核心原因是我觉得语音(和视频)作为人类最为重要的一种沟通方式并且内容已经大爆发,但其内容形态一直都没有得到更好的利用起来。

这主要在于技术的限制,直到这波 AI 爆发,似乎让我们看到了语音(和视频)有可能得到像处理文字一样更高效的处理,这也是我对昨天文章里英伟达投资的视频搜索 AI 这个方向比较看好的原因,也让像 ElevenLabs 和 HeyGen 这样的产品获得爆发式增长。

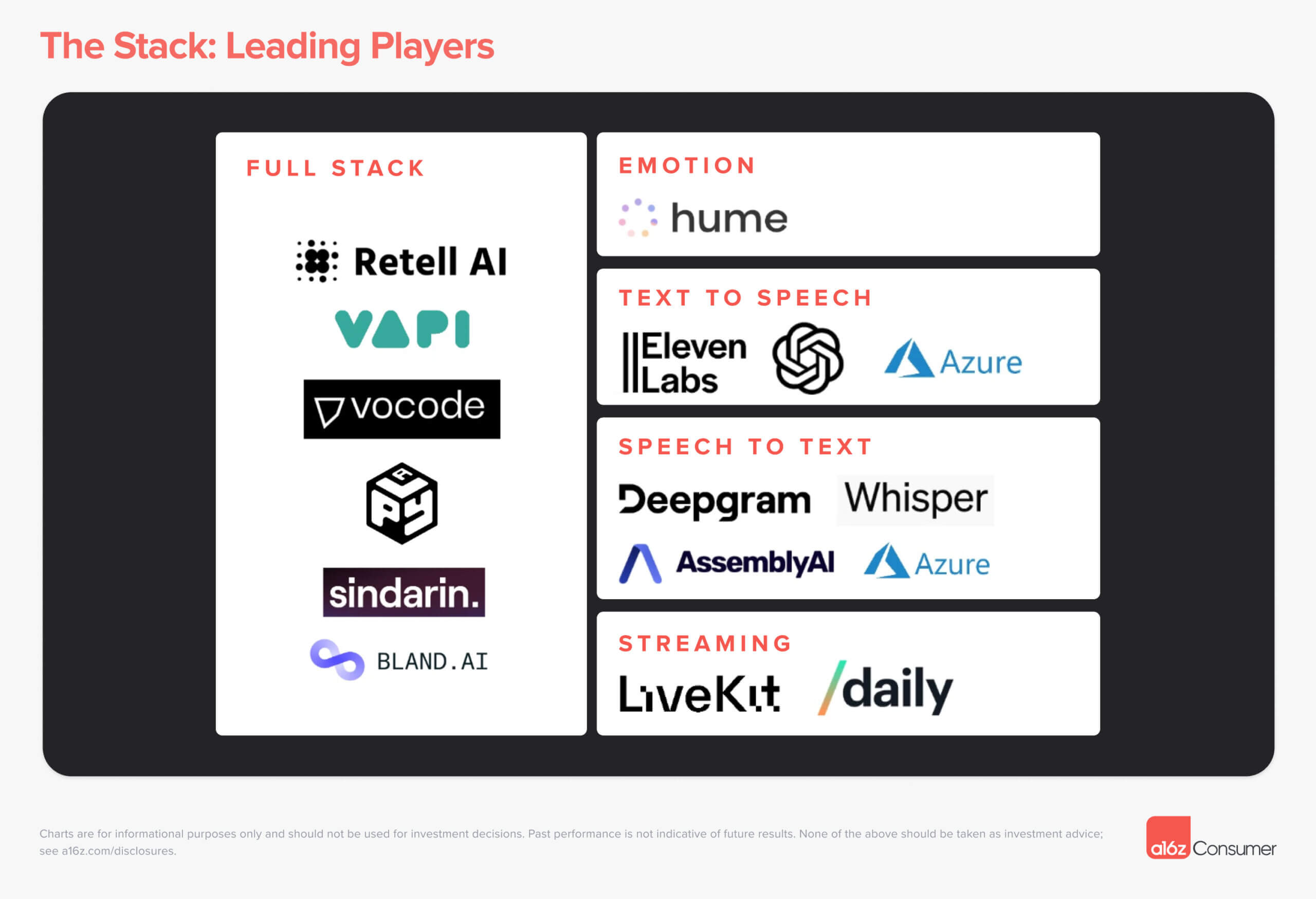

在上周分享的语音 AI 行业图谱一文中,a16z 甚至把它作为了一个独立的投资主题,我想关于这块的机会也会是 VC 接下来比较关注的一个领域。

今天体验了一下 YC 最近孵化的 PocketPod,我觉得这是未来播客发展方向的一个探索,它完全由 AI 生成,根据你的兴趣爱好从互联网上获取内容生成播客。无论是每日新闻更新还是对特定主题的深入研究,它都可以让人们以熟悉的播客方式来消费信息。

其声音基本上让你感受不到是一个 AI 生成的,我设定了技术、创业公司以及 AI 作为核心的三个关键词,很快就给我生成了一个 16 分钟的两人对话式(一男一女)播客,内容基本上都是关于这几个关键词的。

它还将整个播客的内容还分成了 4 个部分(类似于段落),并且整个播客的过程中可以选择不同类型的背景音乐(目前只有 3 种可选),你还可以将它同步到播客分发平台比方说 Spotify。整个产品目前还比较简单,但已经很有基于 AI 来构建个性化播客的雏形了。

市场对语音的需求自然就催生了对基础设施产品的需求,我之前关注过的一个产品在最近就又拿了 2000 多万美金的投资,估值超过了 1 亿美金。

其解决的核心问题是为构建实时语音和视频驱动的 AI 应用提供基础设施,它可以将实时语音和视频无缝嵌入到任何应用中。

其定位比较意思,如果说 OpenAI / Anthropic / Mistral / Meta 正在构建大脑(基础模型),那么这个产品正在构建一个神经系统(网络基础设施),将信号传递到大脑(基础模型)并从大脑传递出来。

而它能快速拿到这轮融资的主要原因就是 AI 大模型多模态的快速发展,之前大家一直觉得 AI 能实现看、听以及说这种多模态需要 5 年时间,但没想到在今年就突破了。

包括像 OpenAI 和 Character AI 这样的 AI 企业已经成为其客户,比方说 ChatGPT-4o 里那种快速的语音功能就由其提供技术支持,目前 10 大未上市公司里的 4 家和财富 50 强里的 6 家都是其客户,并且应用场景也扩张到了机器人等更多领域。

于是大量投资人快速跟进完成了这次投资,投资人里包括了 Solo VC Elad Gil、Perplexity CEO、Pika CEO 、ElevenLabs CEO 以及 Google 首席科学家 Jeff Dean 等一大批 AI 领域的大拿。

除此之外,还包括了 Altimeter 和 Redpoint 这样的机构,由 Altimeter 领投,这轮共融了 2270 万美金,加上之前的融资总共拿了 3800 万美金,估值 1.1 亿美金。

这个产品就是 LiveKit,其创始人在官方博客里说,AI 正在加速计算领域的巨大范式转变。计算机越像人类,我们就越不适应它们,而它们越适应我们。我们用眼睛、耳朵和嘴来交流。类人计算机使用摄像头、麦克风和扬声器。虽然一些输入处理发生在设备上,但负责规划、推理或执行操作的大型人工智能模型在云中运行。

因此尽快将语音或视频输入从你的设备传输到 AI 模型,并将生成的输出返回到你的设备是一项挑战。大脑需要神经系统来来回传输信号,而现有的互联网基础设施并不是为实时传输高带宽数据而设计的,这就是 LiveKi 想解决的问题。

一开始他们是专门为人类进行在线会议而设计的,团队设想未来实时语音和视频对于应用程序来说与数据库一样重要。在未来,需要一个灵活的开源堆栈,任何开发人员都可以使用它来构建任何类型的基于实时语音或视频的应用。

虽然他们不知道这个未来有多长,但是 18 个月时间就有 2 万多名开发者使用,这些开发者来自企业、政府、视频游戏开发者甚至手术机器人和外科医生等领域。并且还跟 OpenAI 和 Character AI 等 AI 企业合作,让他们的 AI 模型具备看、听和说的能力。

创始人说之所以他们的产品受到关注,是因为当前的互联网基础设施并未针对多模态数据进出人工智能模型进行优化。这在一定程度上是因为,每次有人发送一段信息或请求时,发送方首先需要得到一个确认并确认已收到数据"包"的响应,然后才能发送更多数据。 重试 错误原因

这通常是为了确保数据在传输过程中不会丢失。当你只关心文本时,这种延迟几乎不会引起注意。但对于视频和音频等高带宽数据,没有足够的时间在每次传输数据时发送通知,同时还要确保操作的流畅性。

为了解决这个问题,LiveKit 使用了一种名为 UDP 的协议,它允许应用程序流式传输音频和视频内容,而无需确认每个数据包(缺点是增加了数据丢失的风险)。Perplexity CEO 之所以投资,也是希望为 Perplexity 添加语音功能。

联合创始人兼 CEO Russ D'Sa 说,你仍然可以用传统架构构建一些东西,但这是一种真正可以扩展到大量用户,并且不仅可以扩展到语音,还可以同时使用图像和视频的东西。

目前 LiveKit 的应用场景除了 AI 外,还被用于支持客户支持电话、在医院安排患者预约、在农场驾驶自动驾驶拖拉机,以及处理四分之一的 911 调度电话。

Russ D'Sa 说随着越来越多的公司致力于使语音和视频接口听起来和看起来更像人,一个能够快速移动数据的高速网络将对这些系统的功能非常重要,从而实现与 AI 更灵活的交互。

虽然对技术层面不是特别了解,不过 LiveKit 解决的问题我觉得是未来很多涉及语音和视频的场景非常关键的一个体验。写完文章发现,LiveKit 也在 a16z 语音 AI 图谱里,而另一个类似的产品是图谱里的 Daily。