开始使用 AI:足够的提示Getting started with AI: Good enough prompting

不要让这变得难办Don't make this hard

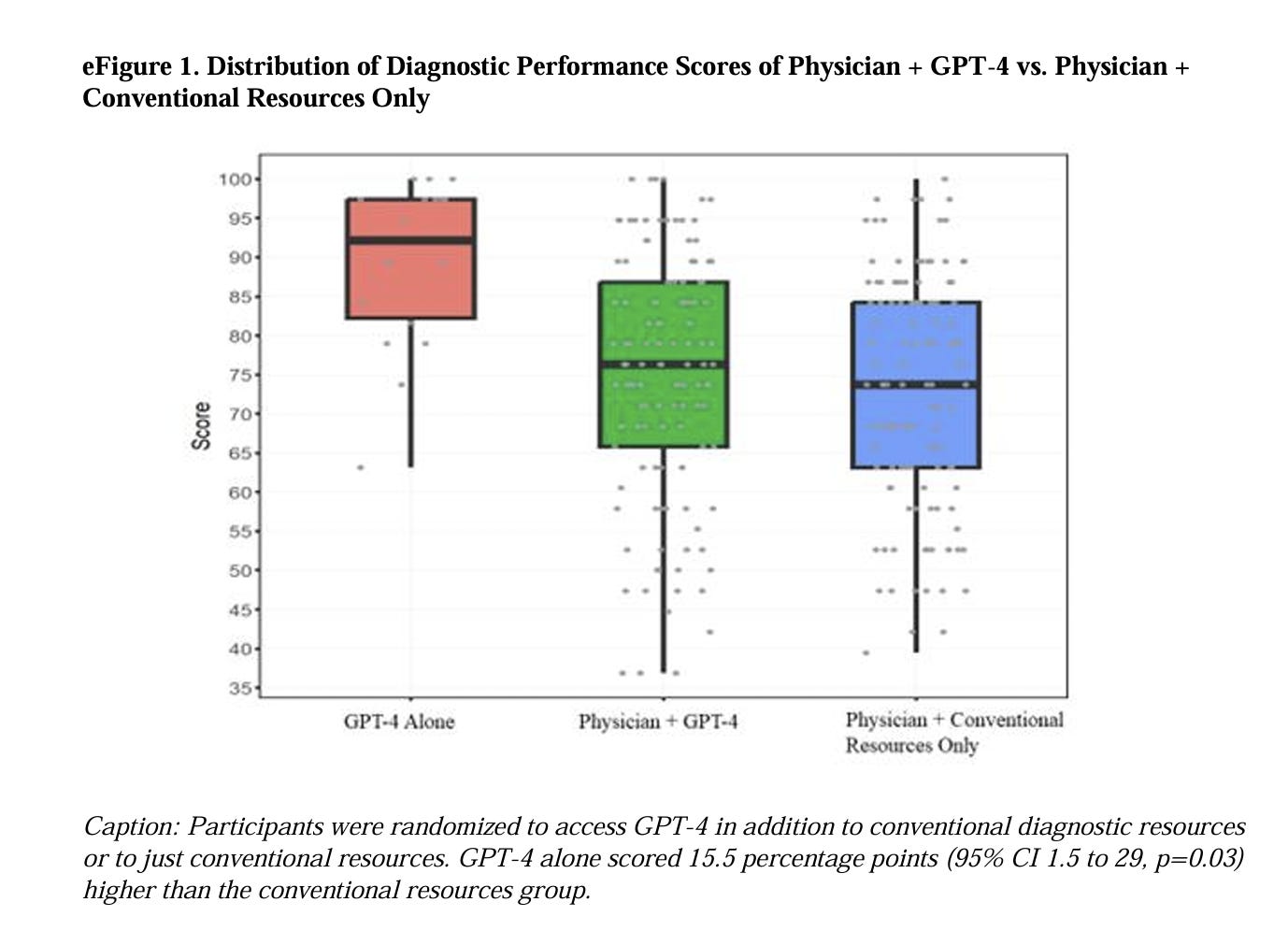

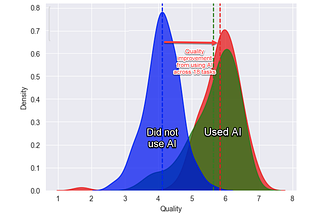

在阅读一篇关于医生使用 GPT-4 诊断疾病的新论文时,我看到了一个熟悉的 AI 问题。这篇论文确认了其他类似研究发现的结论:前沿的大语言模型在诊断上表现得很出色,尽管它们不是专门针对医学设计的。你本以为这种 AI 能让医生更准确,但实际结果却与没有使用它的一样——两组的表现都比 ChatGPT 单独使用时差大得多。 为什么医生们没有从 AI 的帮助中受益?

其中一个原因是算法抗拒。当我们与机器的指令冲突时,我们不愿接受其建议,导致医生甚至在 AI 准确时也拒绝了它。但这个问题的具体原因非常特定于与大型语言模型的工作。对这些系统不熟悉的人发现很难掌握它们,从而无法从中受益。

纽约时报报道:“他们把 AI 视为一个搜索引擎,处理定向问题:‘肝硬化是否是癌症的风险因素?眼睛疼痛的可能诊断是什么?’ 只有少数医生意识到,他们可以将整个病历复制粘贴到聊天机器人中,让机器人回答所有问题。”这不仅仅是医生的问题。 在每个教室或组织中,我讲授的场合,大多数人都尝试了人工智能,但往往因为使用方法的困惑而未能真正理解其功能。因此,在这个过程中,他们没有投入 10 到 15 小时的时间来真正掌握它。

有很多障碍:人们把 AI 当作 Google,问它事实性问题。但 AI 不是 Google,不会提供一致或可靠的答案。或者他们要求 AI 写东西,结果却是一堆通用文本。或者根本不知道该写什么,盯着闪烁的光标发呆。总之,他们无法引导 AI。

解决这类问题的一个常见答案是每个人都应该学习“提示工程”,即让 AI 按预期工作(这更像是艺术)的复杂科学。然而,对于大多数人来说,从一开始就这样做有几点问题:1. 首先,复杂的提示结构可能会让人感到困惑和受限。特别是因为你不需要成为 AI 专家,甚至不需要了解编程或计算机知识就能成为 AI 专家使用 AI 的专家。 建议复杂技能提升是开始点,这会阻止人们使用 AI。其次,提示工程表明有明确的 AI 行为科学,但事实上,研究人员仍在争论基本的提示原则。这是因为 AI 表现不一致且结果各异。 例如,它们对间距和格式的小变化很敏感;当你让他们“再读一遍问题”时,会更准确;他们对礼貌的回应会更好(但不要过度);十二月可能因为意识到冬季假期的概念而变得懒惰。 加上 AI 能在没有大量正式训练的情况下取得好效果,这可能随着更大模型对提示技术的变化不敏感,以及新方法允许 AI 帮助你改进提示。

所以,你可以学习提示工程的细节和LLMs的基本原理,当然,但对大多数人来说,这并不是一个必修课。你需要通过使用 AI 来熟悉你专业领域中可以应用 AI 的地方。最重要的是要花至少 10 小时使用高级 AI 系统。要完成这一点,你只需要成为一个足够好的提示者来克服许多 AI 用户面临的障碍。 开始有两个途径:任务的适当提示和思考的适当提示。

足够的任务提示

使用 AI 的最有效方式之一是帮助完成任务。在我的书中,我讨论了将 AI 带到工作表中,尝试所有工作任务以了解其效果。我认为这仍然是开始的正确方式。通常被建议的做法是将 AI 视作实习生。然而,回顾后我发现这个比喻最终让人们用它来完成非常受限的任务。简而言之,任何最近的前沿模型(例如 Claude 3.5、ChatGPT-4o、Grok 2、Llama 3)都只是在特定领域内表现良好而已。1,或者 Gemini Pro 1.5)可能比你招来的任何实习生都好,但也很另类。

相反,我来提出一个新的类比:将 AI 视为一位非常耐心的新同事,他们每次新对话都会忘记你告诉他们的所有内容。这位同事虽然被高度推荐,但实际能力并不明确。我就是这么看待 AI 的。 这两部分类似于与人类工作(新员工和同事)以及两部分非常不同(忘记一切,永远耐心)。我们应从 AI 最接近人类的地方开始,因为这关系到好的提示

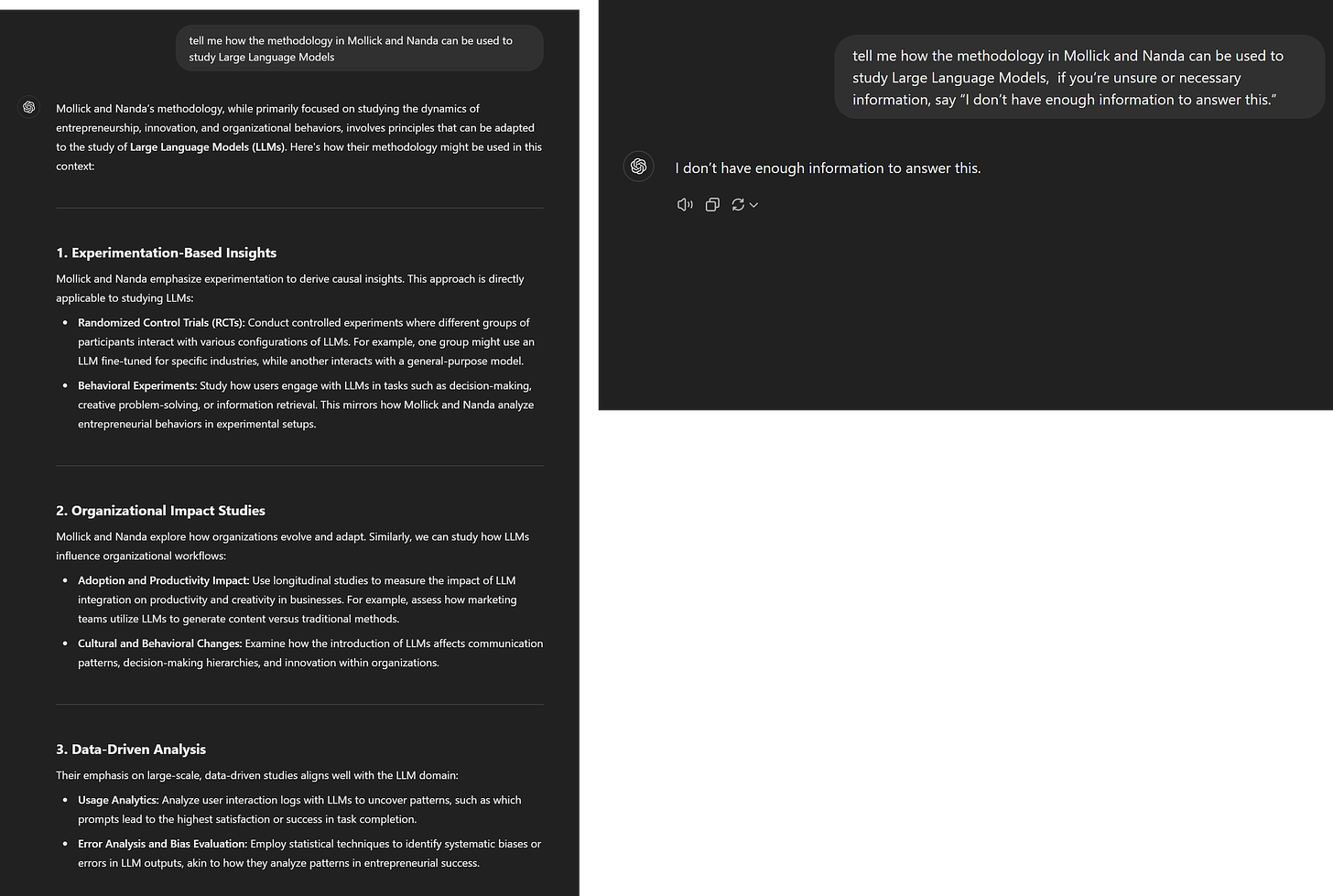

作为同事,你希望与它合作,而不是只是给它指令。你还需要了解它的长处和短处。从开始时,先用在你的专长领域,这样你可以快速判断 AI 的能力边界。因为你是专家,可以快速评估 AI 的正确与否。但需要准备好它可能会给出合理的但错误的答案,不要被这些幻觉吓倒。 虽然幻觉是不可避免的,但你会逐渐意识到它们的重要性,以及它们不重要时。通过让 AI 有错误的能力,例如:如果你不确定或必要信息,请说“我没有足够的信息来回答这个问题”,这可以大大减少幻觉的发生频率。

当我问 ChatGPT 一篇由合著者和我共同撰写的论文时,它生成了一些非常合理的(几乎正确)内容。截图只显示了一部分。然而,因为我是在我的专业领域使用 AI 的,所以我立刻发现了问题。让 AI 报告它自信时的问题也有帮助。

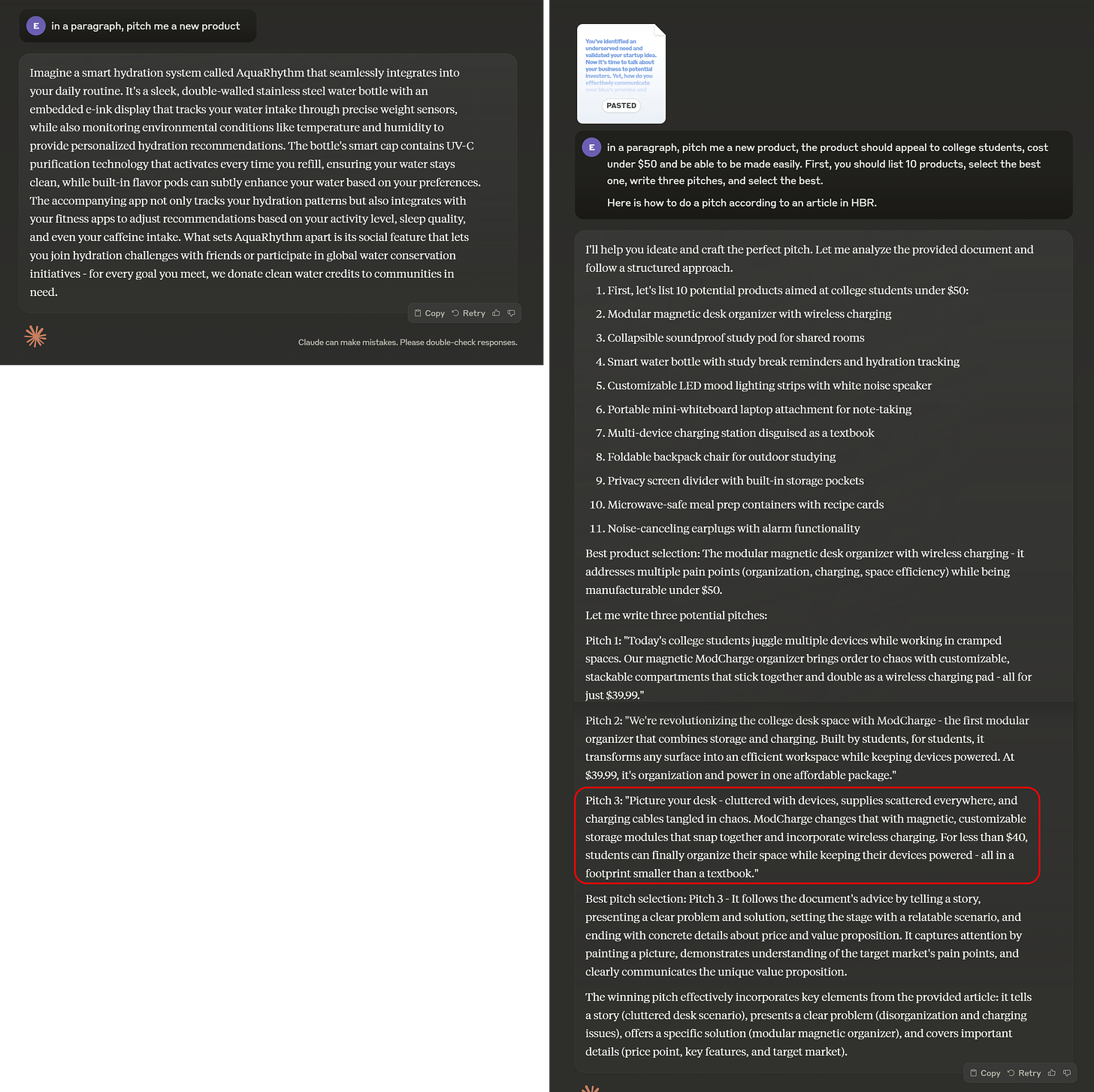

由于 AI 是新入职的,所以你需要非常明确地表达你的需求。你不需要报告远程学习的利弊,你需要的是适合中部美国地区大学的报告,这能说服商学院院长资助新的远程学习项目。 其他方法帮助 AI 明了,比如提供好的或坏的响应示例(称为少样本提示),并给出明确的指导,说明你想要完成的任务。你也可以像别人一样给它反馈,要求它改进,或者直接请求它回答任何不清楚的问题。与 AI 互动是对话,不是命令。

现在我们来谈谈人工智能的非人类特性,比如它的遗忘——每次新的对话都会清除 AI 对你特定情况的理解。因此,你也需要提供上下文。上下文可以是角色或个性(像一个营销人员),但要小心这些,因为虽然角色帮助 AI 理解你的上下文,但这并不意味着它会变成一个真正的营销人员(实际上它并没有真正实现这一点)有时给 AI 分配角色反而会降低准确性。 尝试角色扮演,但如果你觉得它们不必要,就不用用了。你也可以直接提供你周围所有信息。完整的文档、操作手册,甚至之前的对话通常都很有帮助,但记得要关注 AI 的记忆和上下文窗口。

最后,我们迎来了无限耐心,这是人工智能中最缺乏的人性特质之一。事实上,关于 AI 最难以理解的一点是它不会对你生气。你可以一直问问题、不断做出改变,它永远不会停止回应。这为智力生活带来了新事物——丰饶。你不需要一次发一封邮件,而是用不同的语气发三封邮件来激励你。 你不需要要求一种完成句子的方式,而是提供 15 个选项,看看这是否能激发你的写作。不要要求 5 个想法,要提供 30 个。事实上,我们的研究发现 GPT-4 在生成大量想法之前就能出现重叠。你的任务是推动多样性(“给我那些 80%离谱的想法”),组合(“将第 12 和第 16 号结合”),以及扩展(“更多像第 12 号这样的想法”,再选择一个你喜欢的)。

足够的思考提示

除了从 AI 获取工作成果,你可能只是需要一些建议、思考伙伴或有人可以聊天。人们想要这些的原因各不相同。即使 AI 的建议并不总是很有用,你也可以把它当作一个橡皮鸭——计算机编程中流行的观念,如果你把问题解释给 desk 上的无生命的橡皮鸭,你就会通过交流解决问题。例如,我与一位量子物理学家交谈过,他说 AI 帮助了他理解物理学。 当我问他 AI 是否是个好物理学家时,他说不是,但很有趣,鼓励他思考自己的想法。AI 在工作。但 AI 实际上也可以提供有用指导。例如,如果你有能力执行它,AI 可以提供好的战略或创业建议。 除此之外,在控制实验中,与人工智能交流似乎能减少孤独感,但使用 AI 进行治疗或陪伴的全貌和风险我们还不清楚,所以我建议谨慎行事。

为了找到一个思考伙伴,使用 AI 的关键是进行自然对话。只需和它聊天。大多数人通过手机语音最方便。目前最好的语音模型是 GPT-4o,可以通过 ChatGPT 或 Copilot 应用访问。Google Gemini 的语音模型略显简单但仍然可行。其他模型的语音模式即将推出。

不要让这变得难办

最能帮助你理解 AI 的事情就是使用 AI。人们快速放弃使用 AI 的原因很多,从早期的幻觉(AI 不够好)到感到不适(AI 太好),但这些最初的反应随着时间会逐渐缓和。你的目标很简单:花 10 小时在对你有实际意义的任务上使用 AI。之后,你会自然地意识到 AI 在工作和生活中的作用。 你会发展出有效的提示方法,更好地理解 AI 的潜力。不要追求完美 - 从头开始,边学边做。

一个重要的限定条件是“大多数人”——如果你正在构建一个预期其他人会使用的提示,或者在大规模使用时被引入的提示,或者在准确性上至关重要,那么提示工程就非常重要。我有几篇帖子解释了一些这些方法,Anthropic 也有很好的提示工程指南。如果你只是作为 AI 的一部分参与一次性的对话或任务而使用 AI,则这一点尤为重要。

关于人们把 AI 比作 Google,我深有同感。

真正的问题不在于教编程,而是彻底改变人们对 AI 的看法。如果 AI 教育更注重培养实验思维,将 AI 视为通过错误学习来共同进步的伙伴,而不是专注于技术技能,那会怎么样?

这可以填补模型能做什么和实际使用情况之间的差距。

非常重要的点:

人们把 AI 当作 Google,问它事实性问题。但 AI 不是 Google,不会提供一致或可靠的答案。

我经常听到的批评中,与之相关的