为了科学的诚信,我们必须信任自己的进展衡量方法。

@lmarena_ai 已经成为评估 AI 进展的首选工具。

我们今天的发布展示了在 @lmarena_ai 上保持公平评估的难度,尽管我们有最好的意图。

@lmarena_ai 隐性测试政策,实际上只让一小部分供应商受益。

提供者可以选择要公开的评分,并撤回其他所有评分。

在极端情况下,我们看到在发布前会测试多达 27 个模型。

我们还发现竞技场数据访问存在显著差异

@lmarena_ai 是一个开放的社区资源,提供免费反馈,但 61.3% 的数据是为专有模型提供商的。

@lmarena_ai 这些数据差异源于一些有利于少数几家提供商的关键政策:

1) 专有模型以更高频率采样,从而更多出现在战斗中 📶

2) 开放权重和开源模型在竞技场中更频繁地被移除

3) 几个私有变体

这份论文让我们作为一个社区,面对自己,写得让人很不自在。

作为科学家,我们必须做得更好。

作为一个社区,希望我们能要求更高。

为这次跨机构合作感到非常自豪 @Cohere_Labs @UWaterloo @stai_research @PrincetonCITP @uwnlp @MIT

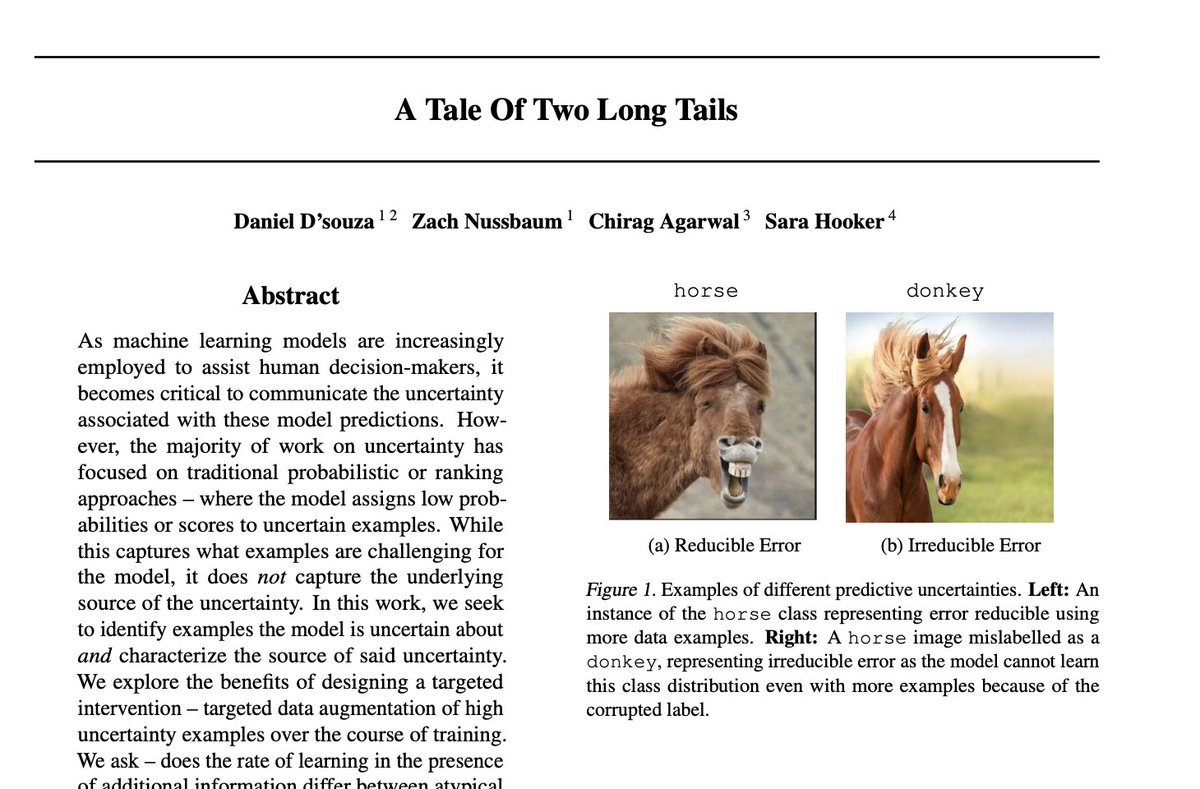

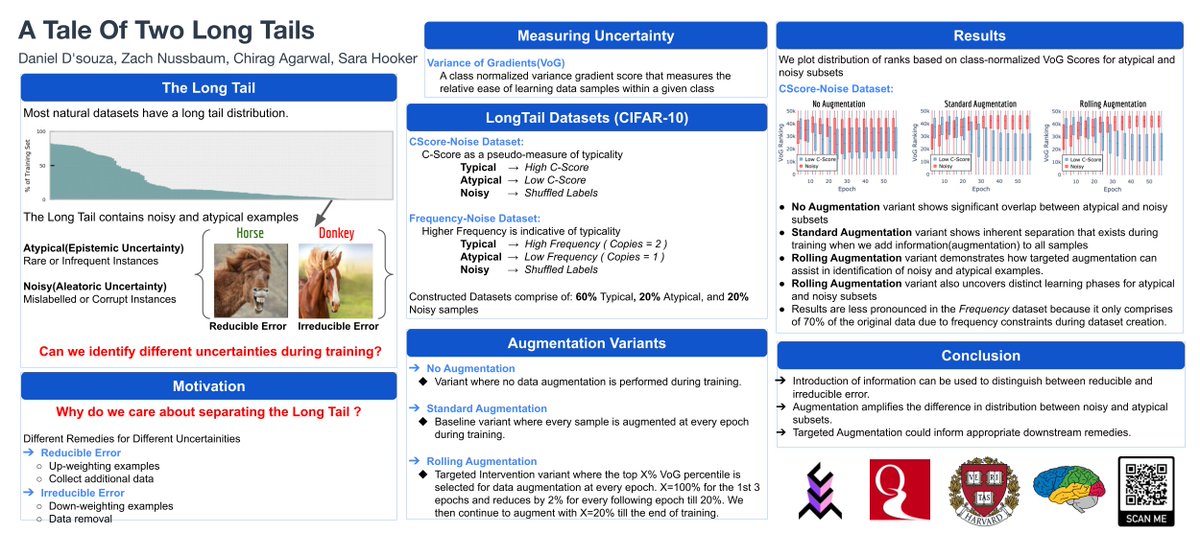

由 @singhshiviii、@mziizm 领衔,共作者包括 @YiyangNan、@W4ngatang、@mrdanieldsouza、@sayashk、@ahmetustun89、@sanmikoyejo、@yuntiandeng、ShayneRedford 和 @nlpnoah

• • •

这个帖子中缺少了某个推文?你可以尝试强制刷新